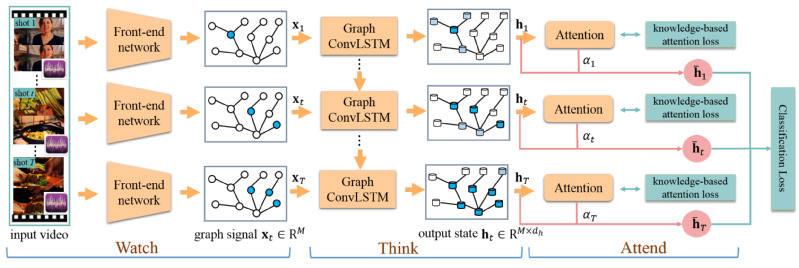

近年来,在多媒体研究领域,通过自动挖掘潜在概念(如行为、事件等)进行视频分类的方法获得了极大的成功,并在视频智能分析领域扮演着重要的角色。然而,大部分现有算法只利用了这些概念的视觉信息却忽略了如何利用外界知识信息来建模动态演变的视频中的概念关系。事实上,人类具备优越的能力来利用获取到的知识感知动态变化的外部世界。为了减少算法与人类之间的知识鸿沟,我们提出了一个端到端的视频分类框架,其利用结构化的知识图谱建模视频随时间变化的动态知识演化过程,如图1所示。这里,我们将视频中的概念映射为知识图谱中的节点。为了高效的利用知识图谱,我们采用了一个graph convLSTM模型来同时识别视频片段中的局部知识结构且建模这些连续的视频片段之间的动态知识演化。另外,我们设计了一个新颖的基于知识的注意力模型来考虑不同视频片段和概念之间的重要性。在UCF101, Youtube-8M等大规模数据集上进行的实验证明了提出方法的良好性能。研究成果发表在国际会议ACM MM2018上。

图1. 视频动态分类框架