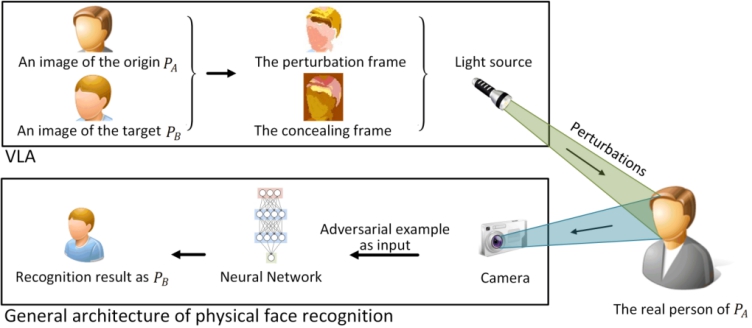

对抗性实例攻击已经成为基于神经网络的人脸识别系统日益严重的威胁。由像素级扰动合成的人脸图像产生的敌对实例,会改变输入的关键特征,从而导致神经网络的误分类。然而,复杂的物理环境造成的扰动损失有时会使现有的攻击方法无法发挥作用。在本研究中,我们专注于设计在物理世界中有效且不显眼的新攻击。由于相机和人眼在成像原理上的差异,我们提出了VLA,一种利用可见光攻击黑箱人脸识别系统的新方法。在VLA中,基于可见光的对抗性干扰被制作并投射在人脸上,这允许敌人进行有针对性或非针对性的攻击。VLA将对抗性扰动分解为扰动帧和隐藏帧,前者对人脸图像添加修改,后者使这些修改对人眼显示不明显。我们进行了广泛的实验,以证明在物理场景下由VLA制作的对抗示例的有效性、不显著性和鲁棒性。

本研究由清华大学、北京理工大学在本项目的支持下完成,发表在CCF推荐A类国际会议ACM UbiComp上,原文可由链接https://dl.acm.org/doi/pdf/10.1145/3351261查看。