近年来,联邦学习被认为是破解工业、企业大规模组织或商业联盟“数据孤岛”现象的重要可行手段,利用加密技术,实现多数据集间非数据交换的服务共享和模型聚合,可以极大地提高企业效率,提升数据价值。然而,在分布式情况下,无法在获得模型聚合结果之前剔除质量较差的数据集,造成无谓的计算浪费和学习能力下降。同时,由于无法通过人为认证预分配密钥,传统基于环境近似性或信道对称性的密钥配对方案只能解决两方配对问题,在多数据集密钥协商时效率低下,甚至因为无法提取共有特征而失败。针对这一问题,本课题充分利用分片密钥重组特性,通过随机抽样一致策略验证数据集低质量数据的比例,在不泄露数据集内容的条件下实现了快速高效准确的多数据集密钥共享问题,而将低质量非适用数据集排除在外,实现了零知识泄露的高质量成员选择。课题组假定有M个适用的数据集(设备)Pi和非适用的数据集E。联邦成员希望彼此进行数据集验证与选择,并构建一个秘密信道以对等方式进行合作。因此,它们同等地贡献部分密钥Si并使用总和S=ΣSi来构造秘密信道。Pi和Pj是任意两个适用数据集,数据集E则质量比较低,希望混入联邦学习框架以提升性能。

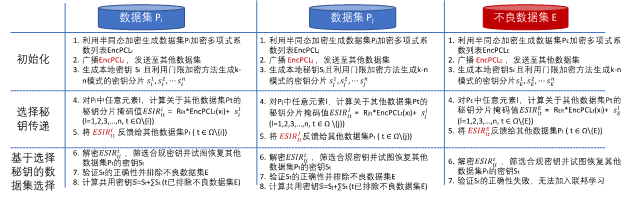

如图1所示,课题组通过以下3个步骤构建Pi间的秘密信道以实现协同训练,而将E排除在外,且不泄露任何成员信息给E:1)每个数据集初始化其配置,例如,生成其秘密片段,并开始对其他数据集数据进行加密的安全交集运行(Private set intersection,PSI);2)每个数据集计算与其他数据集的集合交集,并返回附加密钥秘密方的计算结果;3)每个数据集对反馈信息进行解密,并尝试恢复密钥。验证密钥后,计算最终密钥S=ΣSi,建立秘密信道进行联合训练。如果数据集质量较差,则由于获得的分片密钥不足,无法还原密钥,则将无法通过身份验证并被排除在联邦学习处理之外。此外,课题组也考虑了该选择方法的安全性,传统的PSI方法由于会反馈集合重叠,可以为不良数据集E提供额外信息,供其修改以欺骗其他成员,但在本工作中Shamir分配密钥对元素信息进行掩盖,Eve 几乎无法猜测 Pi 中的任何元素,从而保护了合法成员的信息安全。该课题形成的科研成果已发表在IEEE Intelligent System 2020上。

图1. SMSS流程图